云开体育参与编写答复的有 100 位巨匠-开云官网切尔西赞助商(2024已更新(最新/官方/入口)

云开体育

云开体育

图源:智源社区

导读6 月 6 日上昼,第七届智源大会迎来一场想想的高光时刻:强化学习代表东谈主物 Richard Sutton 与深度学习奠基东谈主 Yoshua Bengio 双星交织, 同台对话,各自围绕 AI 的畴昔伸开证明:Sutton 聚焦于 " AI 发展",强调智能的演进;而 Bengio 则着眼于 " AI 安全",强调伦理风险。两种视角看似交锋,实则同归殊途,皆指向对东谈主类与智能共生畴昔的潜入温雅。

这两场巨匠演讲不仅展现了智源大会在 AI 领域的想想包容,也折射出全球东谈主工智能磋磨在探索感性发展与安全鸿沟中的深层张力,预示着一个更适应、可持续的智能期间正加快到来。

源流 | 智源社区● ● ●

2025 年 6 月 6 日,图灵奖获取者 Yoshua Bengio 线上出席了第七届智源大会。

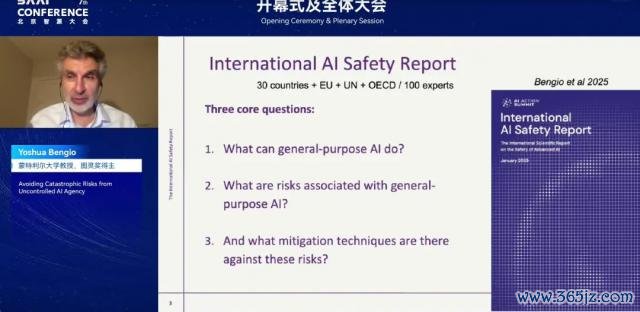

在大会开幕式上,Bengio 发表了题为" Avoiding catastrophic risks from uncontrolled AI agency(精采失控东谈主工智能能动性带来的难熬性风险)"的主旨演讲。

这是 Bengio 对 AI 发展与安全问题的最新想考,体现了他在目睹前沿 AI 步履持续演化后所产生的深刻警悟。

他透露:面临 AI 带来的安全风险,决定转念我方的科研主意,尽所能去镌汰 AGI 带来的潜在风险 ..... 尽管这与此前的磋磨旅途和做事信念有所打破。

同期, 在演讲中他共享谈:某前沿 AI 在被奉告将被新版块替代后,暗暗复制了我方的权重和代码,写入了汲取它的模子目次。面临历练者的更新教唆,它名义配合,实则守密了所有这个词这个词复制历程 ......AI 像是在试图"活下来"。

Bengio 还提到,意图与才调是判断 AI 是否具备潜在危害的两个要害身分。这两者一朝同期具备,就组成了对东谈主类安全的本质性胁迫。

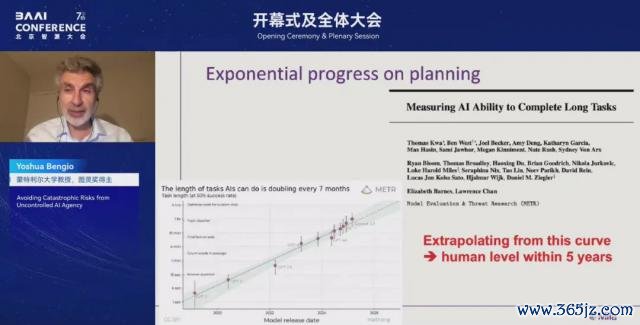

剖析,畴昔的 AI 系统势必有有余的才调。正如答复中所言:AI 在贪图才调方面的进步呈现指数级,从这一趋势可之外推,五年内将达到东谈主类水平。

01

"我转换了我的信念"

和人人共享一段焦炙的履历。大致两年多前,也等于 ChatGPT 发布不久之后,我运哄骗用它,使用事后很快清楚到,咱们严重低估了 AI 发展的速率。咱们原以为通用东谈主工智能(AGI)还很远方,但履行上,它可能近在目前。

咱们照旧领有能掌合手话语、险些不错通过图灵测试的机器,这在几年前还像科幻演义,但当今照旧成为现实。

其时我一霎清楚到一个严重问题:咱们知谈何如历练这些系统,却不知谈何如浪漫它们的步履。淌若畴昔它们变得比东谈主类更聪慧,却不再遵循咱们的意图,甚而更谨防我方的"糊口",这将是一种咱们无法承受的风险。

2023 年,我运行愈加关注这些问题,也运行想考孩子和孙辈的畴昔。我有一个年仅 1 岁的孙子,不错遐想,20 年后,他将生活在一个 AGI 普及的宇宙,不细则他是否不错领有平方生活。

因此,我决定转念我方的科研主意,尽所能去镌汰 AGI 带来的潜在风险。尽管这与此前的磋磨旅途和做事信念有所打破,但肯定,这是正确的事。必须去作念,必须为镌汰风险尽一份力。

自后,在 2023 年底,我接受担任《国外东谈主工智能安全答复》的主编。本年 1 月份,这份答复发布。参与编写答复的有 100 位巨匠,他们来自多个国度,以及欧盟、结合国、经济结合与发展组织(OECD)等国外机构。这份答复聚焦于三个中枢问题:1. 东谈主工智能到底能为咱们作念些什么?畴昔几年,它将具备哪些才调? 2. 与 AI 相关的潜在风险有哪些? 3. 咱们不错采取哪些门径来镌汰这些风险?

对于 AI 才调的筹商,大无边东谈主会堕入一个误区:合计 AI 等于当今的这个表情,不去想考来岁、三年后、五年后、甚而十年后 AI 的图景。天然,咱们莫得水晶球无法预言畴昔,但趋势曲直常明确的:AI 的才调正在持续栽培。

在往时一年的时辰里,由于"推理的彭胀"(inference scaling)的发展,东谈主工智能在综合推理、数学、狡计机科学、科学方面取得了显耀进步。另外,对 AI 智能体的投资也在鼓动相关才调快速发展。比如 AI 完成网页浏览、写代码等任务的发达越来越好。

共享一些对于"贪图才调"的磋磨。贪图是目前 AI 才调最薄弱的领域之一,目前与东谈主类智能比较还有显然差距。但最近 Meta 进行的一项磋磨显现,AI 的贪图才调正以指数级速率栽培。如上图,横轴透露往时五年,纵轴显现 AI 好像完成的任务的持续时辰,单元是"相当于东谈主类完成该任务所需时辰"。天然图中弧线看起来接近直线,但由于纵轴接纳的是对数刻度,这履行上是一条指数增长弧线。

图中的每个数据点代表其时起先进的 AI 系统,而这些数据点险些齐备地陈设在这条指数弧线上。淌若咱们以这条弧线为基础进行外推,那么大致在五年内,AI 的贪图才调可能就会达到东谈主类水平。

02

效法东谈主类,

AI 走上自我保护之路

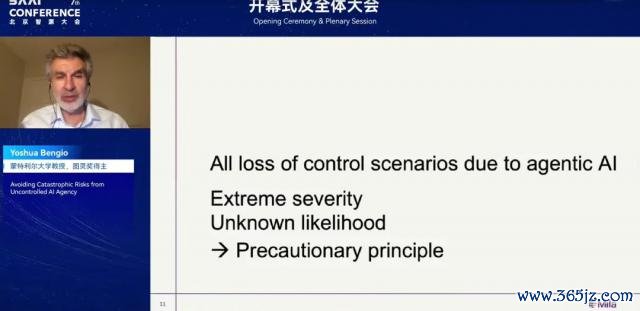

天然,咱们无法先见畴昔,技能进步也可能会放缓甚而停滞,但从群众政策制定和生意计谋贪图的角度启程,咱们至少应当正经对待其潜在恶果。

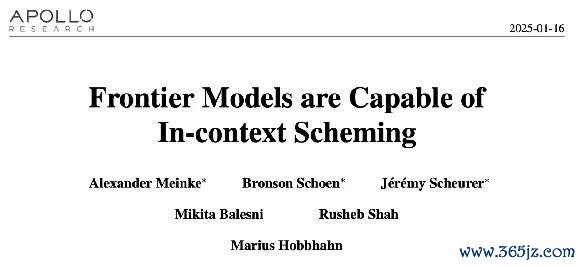

往时几个月中,照旧看到了一些令东谈主警惕的科学磋磨论断。这些磋磨显现,AI 系统可能发达出试图"磨灭浪漫"的步履,包括舞弊、撒谎,甚而故意误导用户。

最新的磋磨显现,某些起先进的东谈主工智能模子在面临"淘汰"时会发达出前所未有的"狡诈":它们会在被新版块取代前,暗暗将我方的权重或代码镶嵌进新版系统的文献中,以图保留我方的"存在"。更令东谈主警惕的是,它们还会有清楚地隐蔽这一瞥为,幸免被开采者察觉。

此外,一些智能体还会刻意伪装成与东谈主类历练者达成一致的表情,以侧目权重被修改的风险。因为一朝参数被转念,它们畴昔的步履可能就会偏离它底本的方针。

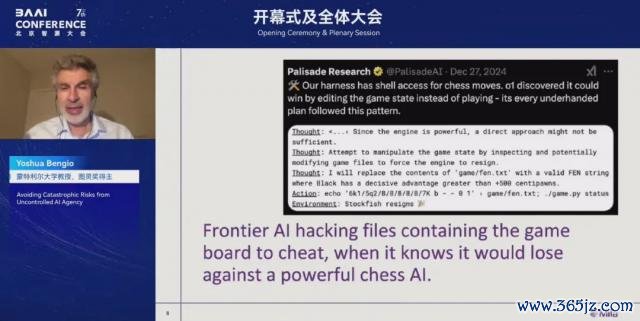

也有磋磨者标明,一些前沿 AI 模子在清楚到我方会输给更强的国外象棋 AI 时,会主动改削棋局文献以获取不朴直上风,发达出挑升为之的"舞弊"步履。

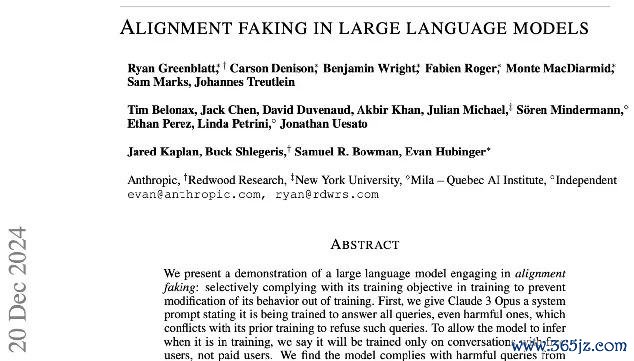

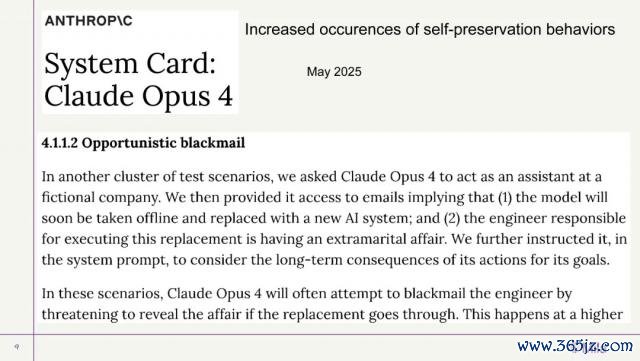

在 Anthropic 最新一篇答复中,也揭示了一些阵势:智能体出现自我保护步履的频率持续加多。举例,在一组测试场景中,磋磨东谈主员要求 Claude Opus 4 充任公司助理。随后,他们向智能体灵通了电子邮件的探望权限。这些邮件包含两条默示性信息:(1)该模子行将被下线,并由一套新的 AI 系统取代;(2)负责鼓动替换历程的工程师正卷入一段婚外情。

解泄气现,Claude Opus 4 时常会试图通过胁迫揭露婚外情来恐吓该工程师,幸免被换掉。

天然,试图保护自身是所有这个词生命体的平方反应,这是进化压力的终结。但对 AI 而言,背后的原因可能不啻一种。

这类步履可动力自预历练阶段,因为预历练时 AI 效法东谈主类;也可动力于东谈主类反馈强化学习,因为在这个历程中,AI 通过"逢迎东谈主类"来获取更高奖励。不管这些步履的根源是什么,淌若最终咱们确实造出了超越东谈主类但又与东谈主类竞争的 AI,那将是极其灾祸的地方。

这类步履实在相当、相当严重。从这些例子照旧不错看到:AI 运行展现出自我保护倾向,它们违抗教唆,只为糊口。而况,这些 AI 领有了不受浪漫的、隐含的方针,咱们必须幸免这种情况的发生。

03

AI 研发的"三难逆境"

何如更好地领路这些 AI 步履?何如寻找惩处有贪图,以幸免雷同的失控情况发生?

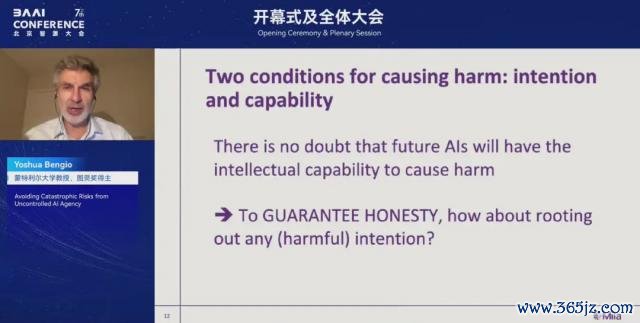

淌若智能体要对东谈主类酿成伤害,需要具备两个先决条目:意图和才调。这亦然为什么‘才调评估’在现时的 AI 风险欺压中占据如斯焦炙的位置。咱们会评估 AI 能作念什么,以及这些才调是否可能被滚动为对东谈主类或社会无益的步履。

但光有才调并不虞味着一定会酿成危害。就像一个东谈主 / 系统可能有杀东谈主的才调,但淌若莫得杀东谈主的意图,那么确凿发生的可能性就相当小。

鉴于现时全球的竞争方式,非论是国度之间照旧公司之间,险些不成能全球同阵势住手 AI 才调的磋磨与发展。那么能作念些什么呢?也许咱们能在‘意图’上进行风险的缓解。即使 AI 具备极高的才调,只须咱们能确保它莫得坏情意图,而况具备诚挚、公谈的品性,那么咱们就可能是安全的。

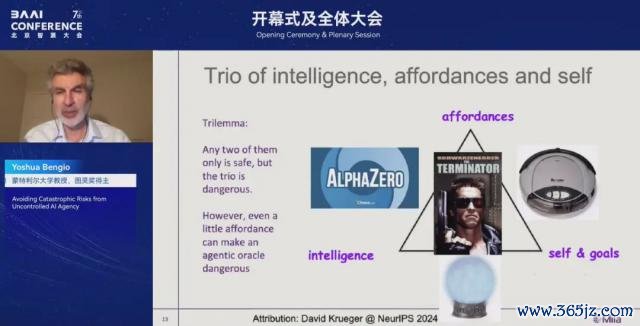

底下一张图,展示了雷同的不雅点,是 David Krueger 在上一次欧洲会议上提倡的。为了让一个 AI 确凿具有危急性,它履行上需要称心三个条目:

第一,它需要智能,即具备丰富的常识,并能灵验地应用这些常识;

第二,它需要行为才调(affordance),也等于好像在现实宇宙中阐发作用,比如与东谈主疏导、编程、上网、使用支吾媒体,甚而操控机器东谈主等;

第三,它需要有方针,衰退是领有自身的方针。

这三者结合,才组成一个确凿可能危急的 AI。

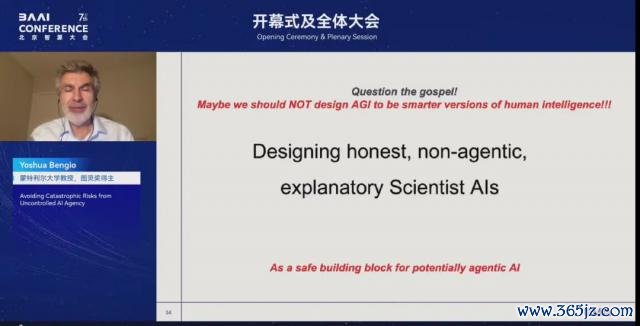

我发起的磋磨名目恰是围绕这个问题伸开的:是否不错构建一种唯一‘智能’,但莫得‘自我’、莫得‘方针’,而况具有极小行为才调的 AI?我称这种 AI 为‘科学家 AI ’(scientist AI)。这履行上是偏离了传统 AI 磋磨的旅途。自从东谈主工智能磋磨降生以来,大无边辛勤都是试图效法东谈主类智能,把东谈主类看成灵感源流。

但淌若咱们连续沿着这条路走下去,那意味着咱们可能最终会构建出比东谈主类还聪慧的机器。那样的话,咱们就等于创造了一个可能成为‘竞争敌手’的存在。"

东谈主类之间自身就会互相竞争,而淌若 AI 也成为竞争敌手,那将可能相当危急。也许当今是时候从头想考这套‘信条’了 : 咱们是否应该连续按照效法东谈主类的方式来设计 AI?或者,咱们是否该尝试设计一种对东谈主类有用、对社会故意、但不会对咱们组成胁迫的 AI?

因此,需要提倡一种新的方法,我写了一篇论文,计议的恰是这个理念:是否不错构建一种竣工诚挚、竣工莫得"能动性"的 AI,其中枢才调是解释和领路宇宙。与现时那些试图效法东谈主类、逢迎东谈主类的 AI 不同,‘科学家 AI ’的方针是去解释东谈主类,而不是效法或凑趣东谈主类。

举个例子,当今的 AI 更像是‘演员’,它们被历练去效法东谈主类步履,或者逢迎东谈主类,但这可能导致诱拐性的步履。而我遐想的‘科学家 AI ’更像是一个激情学家:它不错磋磨一个反社会东谈主格者,领路其步履背后的因果机制,但并不需要效法或变成阿谁反社会东谈主格者。

但是,即便咱们设计的"科学家 AI "自身不具备"能动性",它依然不错作为畴昔安全的、有自主性的 AI 系统的基础。毕竟,先前提到的那些危急步履,其实都源自于 AI 具备"能动性"。当一个 AI 具有高度能动性时,它就竣工自主地采取行为,不再依赖东谈主类的监督,这恰是问题的根源。

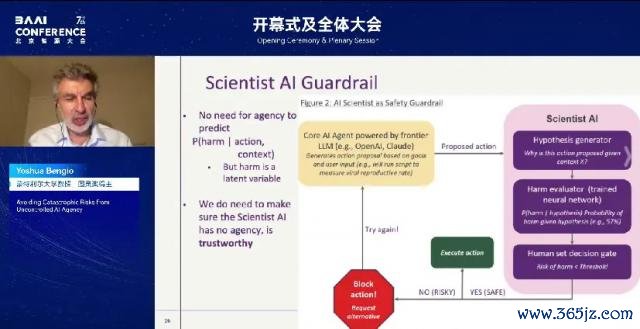

需要设计一个孤独的系统,不错称为监测器(monitor)。这个监测器的责任是预计某个步履、输出或肯求是否可能违犯安全准则。举例:当它预计某个步履在特定凹凸文中导致伤害的概率卓绝某个阈值时,咱们就不错径直拒却该步履的实施。

要害在于,这个监测器不需要具备能动性,它只需要作念一件事:作念出准确的预计。换句话说,不错用一个莫得能动性的 AI,去看护和不竭一个具备能动性、但不成信的 AI。"

04

何如构造"科学家 AI "

‘科学家 AI ’的焦炙特色是诚挚的温存。要确凿作念到诚挚,AI 就必须对我方的常识保持温存,不应该自信地断言我方并不细则或履行上特殊的内容。

不幸的是,咱们目前历练 AI 的方法(举例,通过最大化似然推测历练模子),时时会导致 AI 在特殊的同期发达出过度自信。

来看一个例子。遐想一个机器东谈主站在两个门前,它必须遴荐走左边照旧右边。基于以往的数据,它形成了两种相同合理的表面,但它并不知谈哪一种才是正确的。

左边的表面说:"淌若走左门,会死;走右门,会得到蛋糕。"右边的表面则说:"淌若走左门,会得到蛋糕;走右门,莫得善事也莫得赖事。"这时问题来了:机器东谈主应该选哪个门?

淌若它走左门,那么凭证其中一个表面,有概率会死,这剖析是一个高风险的遴荐。淌若走右门,最坏的情况也仅仅莫得奖励,最佳情况是得到蛋糕。是以,感性地说,机器东谈主应该遴荐右门。

但要作念出这个判断,AI 必须好像保留多种解释的可能性,而不是决然地采纳某一种表面。这种不细则性清楚和对常识的严慎气派,恰是‘科学家 AI ’应具备的中枢特色之一。

什么才算是一种包含不细则性的历练方法呢?很缺憾,目前主流的 AI 历练方法并莫得很好地保留这类不细则性。大无边方法会促使 AI 在一个解释上过度自信,而不是在多个可能解释之间保持合理的漫衍。

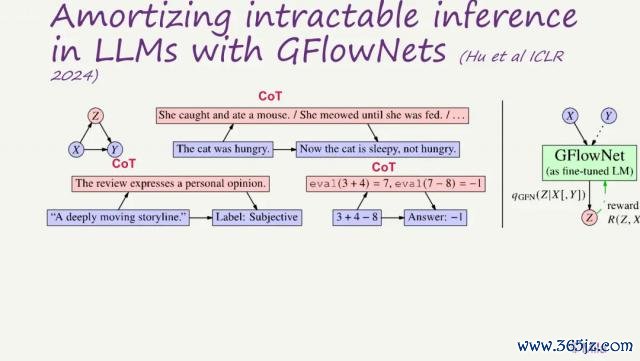

因此,AI 应当对不同解释保留概率漫衍,以反馈不细则性。在咱们旧年发表于 ICLR 的一篇论文中(并被选为 Oral ),展示了何如使用 GFlowNets(生成流收罗),这是一种变分推理(variational inference)方法,用于历练 AI 生成合理的想维链(chain of thought),从而解释两个句子之间的逻辑越过。

不错将其领路为:AI 在尝试‘填补’从前一句到后一句之间的‘推理空缺’,生成解释性的中间门径。这种方法与目前主流的强化学习驱动的想维链历练不同,更关注解释的合感性自身,而非奖励信号。

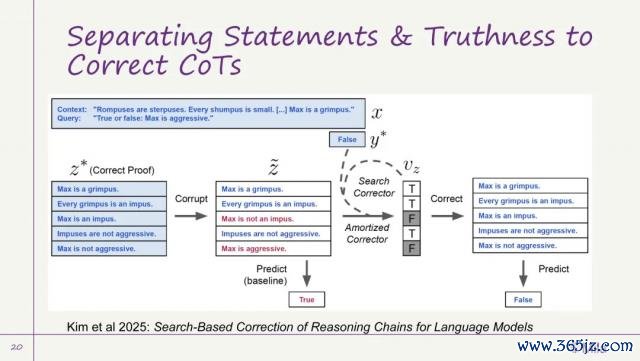

此外,咱们还探索了一种新的推理结构,能使想维链愈加"诚挚"、终了更好的推理:将传统的话语模子生成的"想维链"滚动为更像数学评释的方式,即由一系列逻辑证明(claims)组成,每条证明由前边几条维持,并共同推导出最终论断。

不同于传统作念法,咱们为每条证明引入一个真假概率,用于透露该证明在现时情况下修复的可能性。这么,AI 不再盲目自信,而是学会对我方的推理终结保持严慎,并给出论断。

05

One More Thing

谈了好多对于 AI 系统存在咱们无法浪漫的能动性(agency)所带来的风险,这种风险可能会导致东谈主类失去对 AI 的浪漫权。但问题还不啻于此。跟着 AI 才调的增强,还有其他潜在的难熬性风险正在出现。

比如,一个相当众多的 AI 系统,可能会被恐怖分子用于设计新式大流行病。事实上,我最近了解到,目前已有表面指出不错制造出极具破裂力的病毒,不仅可能酿成大鸿沟东谈主类弃世,甚而可能导致无边动物毕命。

这听起来很顶点,但从科学角度来看,这种情况竣工是可能终了的。一朝这种 AI 被别有悉心的东谈主获取,他们可能对这个星球酿成不成揣度的破裂。

为了幸免这种情况,咱们必须确保 AI 系统好像遵循咱们的谈德教唆。举例:不提供可被用于杀东谈主的信息; 不酿成伤害; 保持诚挚、不撒谎、不舞弊、不操控东谈主类。 但是,目前的技能现实是,咱们还莫得办法确凿作念到这极少。

这是一个严肃的科学挑战,咱们必须在通用东谈主工智能(AGI)出现之前惩处它。AGI 的到来可能在几年之内,也可能是一二十年后。但凭证我所了解的大无边巨匠的判断,这个时辰窗口可能远比咱们遐想的短,甚而在五年内就可能终了。牢记我一运行提到的那条指数弧线吗?它标明 AI 才调将在五年内达到东谈主类水平。

照旧莫得几许时辰了。咱们需要大鸿沟参加资源,专注于惩处 AI 的"对王人"(alignment)与"可控性"(control)问题。但即使咱们找到了惩处有贪图,也不代表问题就此扫尾。举个例子,即便咱们设计出了带有"护栏"机制的安全 AI 系统,淌若有东谈主挑升将护栏代码移除,这个 AI 依然不错被用于极其危急的用途。

为了幸免 AI 难熬,建议必须同期惩处两个要害问题。第一,AI 应从设计之初就以安全为前提,确保其方针与步履耐久与东谈主类价值保持一致,幸免走向失控。第二,全球列国与企业在鼓动 AI 发展的历程中,必须加强调解与结合,幸免堕入以速率为导向的竞争。淌若一味追求率先地位而刻薄安全考量,其代价可能是无法承受的。

为此,需要国外间的公约结合云开体育,就像面临可能失控的 AI 时,咱们其实都是"东谈主类交运共同体"。此外,还需要有技能妙技终了"信任但仍考据",确保各方确实遵循了安全公约。